Blog

4 Chatbot AI miễn phí bạn có thể chạy trực tiếp trên máy tính của mình

Dưới đây là bài viết chi tiết hơn về 4 chatbot AI miễn phí mà bạn có thể chạy trực tiếp trên PC, ngay cả khi không có kết nối internet. Các chatbot này được thiết kế để hoạt động cục bộ, tận dụng phần cứng của máy tính, và phù hợp với nhiều tác vụ như tạo văn bản, trò chuyện, hoặc thậm chí phân tích hình ảnh. Mỗi chatbot có những đặc điểm riêng, yêu cầu phần cứng khác nhau, do đó bạn cần chọn dựa trên cấu hình máy tính của mình. Bài viết sẽ cung cấp thông tin chi tiết về cách cài đặt, sử dụng, và các tính năng nổi bật, giúp bạn dễ dàng lựa chọn chatbot phù hợp nhất.

1. Llamafile: Chatbot đơn giản nhất cho người mới bắt đầu

Tổng quan:

Llamafile là một trong những chatbot AI cục bộ dễ sử dụng nhất. Điểm đặc biệt của Llamafile là nó tích hợp cả giao diện người dùng (front end) và mô hình AI (large language model) vào một tệp duy nhất. Điều này giúp việc cài đặt và sử dụng trở nên cực kỳ đơn giản, ngay cả với những người không có nhiều kinh nghiệm về công nghệ.

Llamafile được phát triển với mục tiêu làm cho AI trở nên dễ tiếp cận với mọi người, vì vậy nó không yêu cầu tải mô hình riêng lẻ. Bạn chỉ cần tải tệp Llamafile phù hợp và chạy nó.

- Tính năng nổi bật:

- Tích hợp sẵn mô hình AI: Không cần tải mô hình riêng, mỗi Llamafile đi kèm với một mô hình cụ thể (ví dụ: Llava cho phép tích hợp hình ảnh).

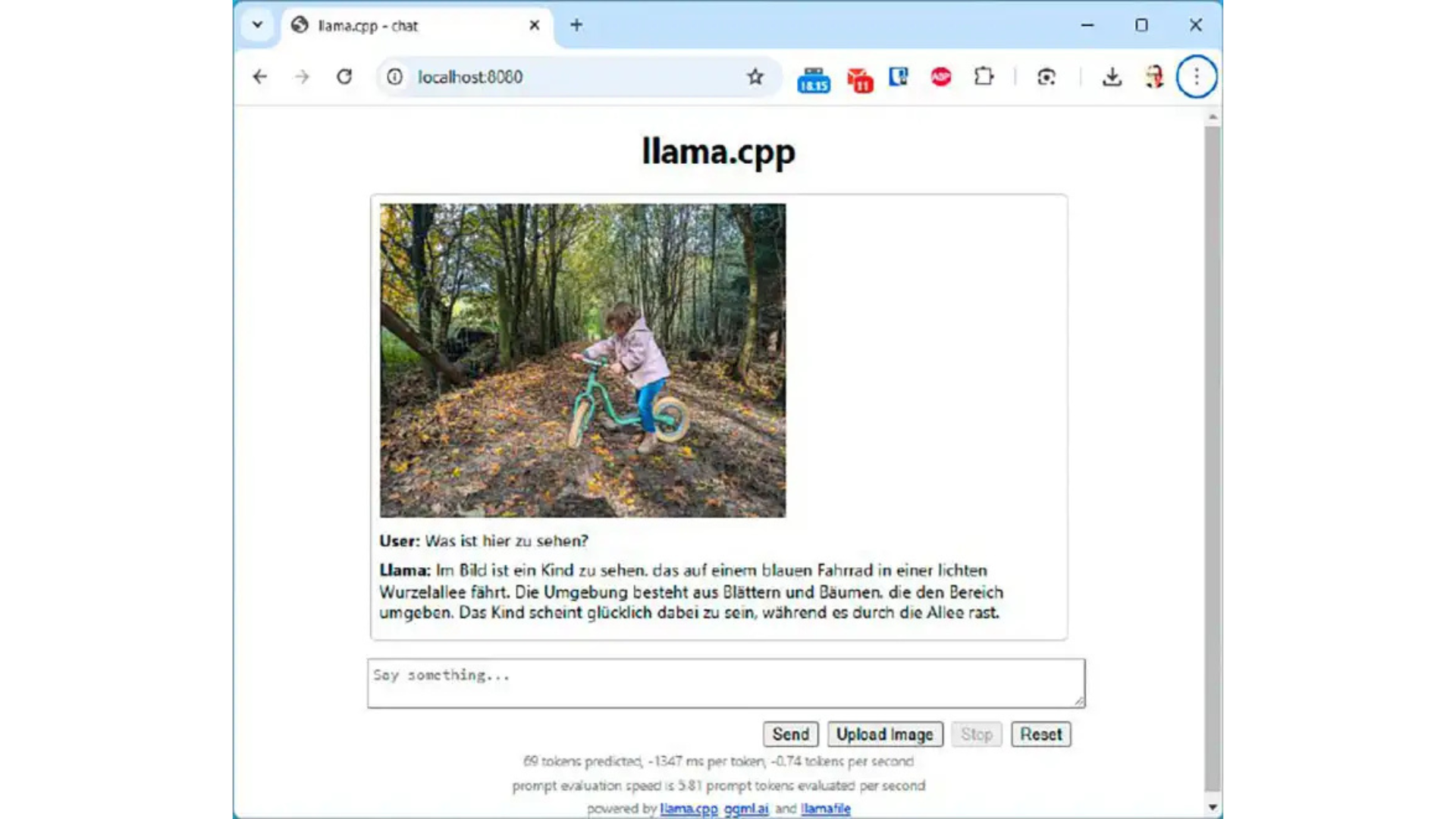

- Hoạt động qua trình duyệt: Sau khi chạy tệp, bạn truy cập chatbot qua trình duyệt bằng địa chỉ localhost:8080 hoặc 127.0.0.1:8080.

- Hỗ trợ hình ảnh với Llava: Nếu sử dụng mô hình Llava (ví dụ: Llava-v1.5-7B), bạn có thể tải hình ảnh lên để chatbot phân tích và trả lời các câu hỏi liên quan.

- Dễ dàng chia sẻ trong mạng nội bộ: Bạn có thể chạy Llamafile trên một PC mạnh trong mạng nội bộ và truy cập từ các máy khác qua địa chỉ IP.

- Cài đặt đơn giản:

- Truy cập trang web chính thức của Llamafile (Llamafile.ai) và tải tệp phù hợp với mô hình bạn muốn (ví dụ: llava-v1.5-7bq4.llamafile).

- Sau khi tải, đổi tên tệp để thêm đuôi .exe (ví dụ: llava-v1.5-7b-q4.llamafile.exe).

- Chạy tệp và bỏ qua cảnh báo từ Windows Defender (nếu có) bằng cách chọn “Run anyway”.

- Mở trình duyệt và nhập localhost:8080 để bắt đầu sử dụng.

- Lưu ý: Nếu muốn sử dụng mô hình khác, bạn cần tải một Llamafile khác từ trang web, vì mỗi tệp chỉ tích hợp một mô hình.

- Yêu cầu phần cứng:

- RAM tối thiểu: 8GB để chạy các mô hình nhỏ như Llava (7B parameters). Với RAM 16GB trở lên, hiệu suất sẽ tốt hơn.

- GPU: Không bắt buộc, nhưng nếu có GPU Nvidia hoặc AMD, tốc độ xử lý sẽ nhanh hơn đáng kể.

- Dung lượng lưu trữ: Mỗi Llamafile có kích thước khác nhau, thường từ vài GB đến hơn 10GB, tùy thuộc vào mô hình.

- Ưu điểm:

- Dễ cài đặt, phù hợp cho người mới bắt đầu.

- Không cần kết nối internet, đảm bảo tính riêng tư.

- Nhược điểm:

- Giao diện người dùng cơ bản, không hấp dẫn về mặt hình ảnh.

- Hạn chế trong việc tùy chỉnh mô hình hoặc tích hợp dữ liệu cá nhân.

- Ứng dụng thực tế: Llamafile phù hợp cho các tác vụ đơn giản như trò chuyện, tạo văn bản ngắn, hoặc phân tích hình ảnh cơ bản. Nếu bạn muốn trải nghiệm AI cục bộ mà không cần cấu hình phức tạp, đây là lựa chọn lý tưởng.

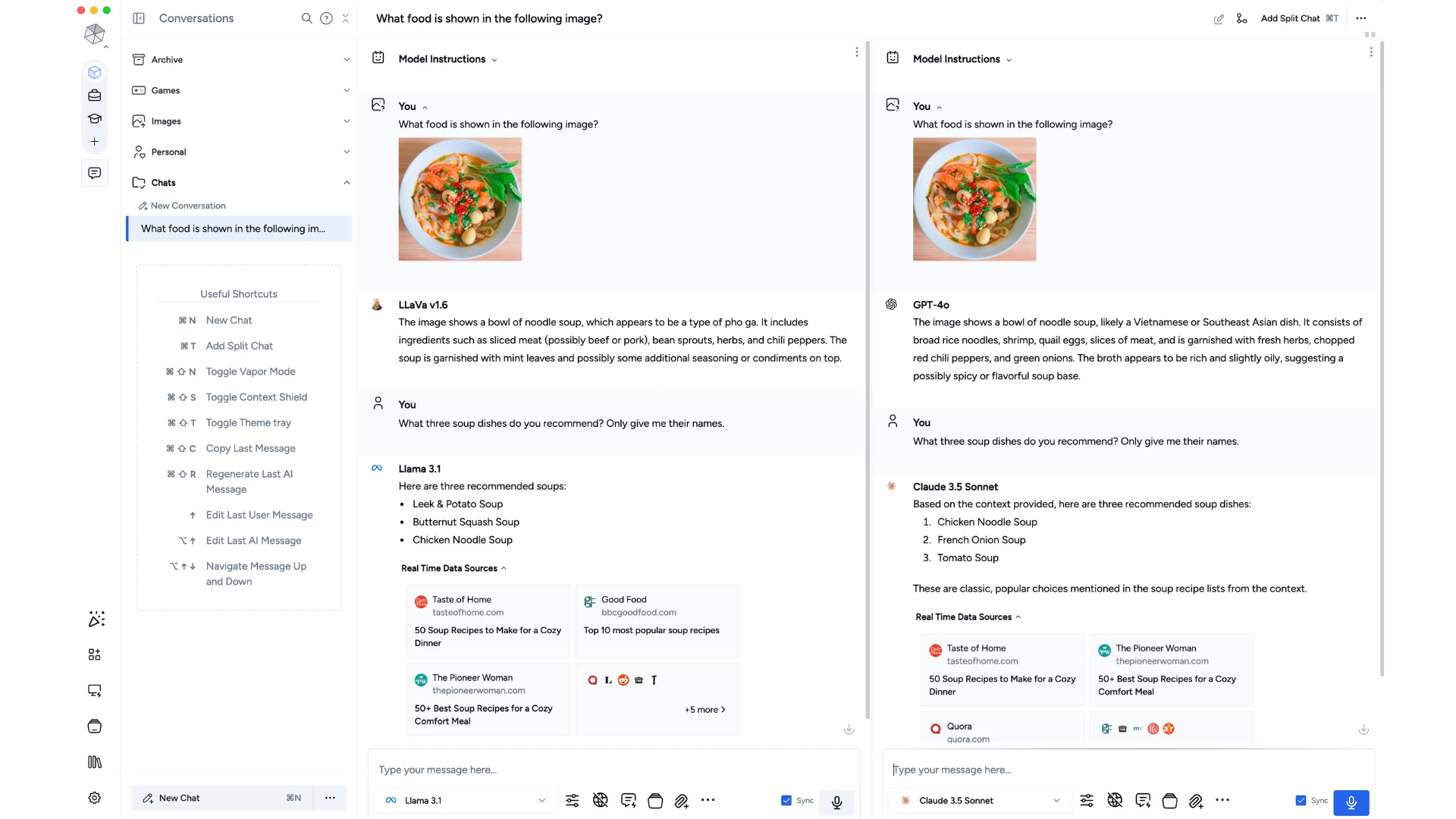

2. Msty: Tích hợp tệp cá nhân mạnh mẽ, đa dạng mô hình

Tổng quan:

Msty là một chatbot AI cục bộ mạnh mẽ, nổi bật với khả năng tích hợp tệp cá nhân (như tài liệu, PDF) vào cơ sở kiến thức của chatbot. Ngoài ra, Msty hỗ trợ truy cập vào nhiều mô hình ngôn ngữ từ các kho lưu trữ như Ollama và Hugging Face, cho phép người dùng linh hoạt lựa chọn mô hình phù hợp với nhu cầu.

- Tính năng nổi bật:

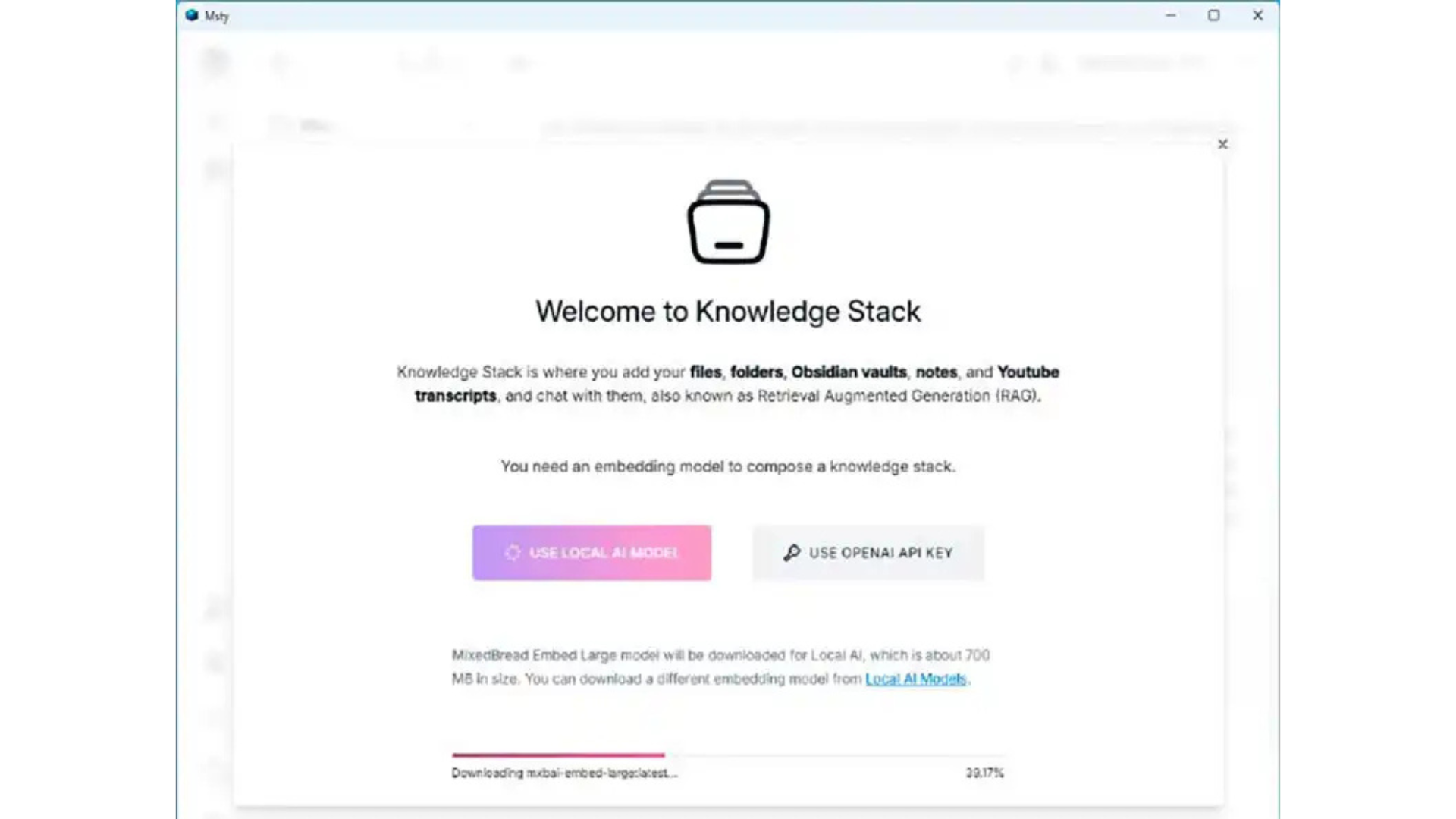

- Tích hợp tệp cá nhân qua “Knowledge Stack”: Bạn có thể tải lên các tài liệu cá nhân để chatbot tham khảo. Đây là tính năng nổi bật nhất của Msty, giúp bạn sử dụng AI để trả lời các câu hỏi dựa trên dữ liệu riêng.

- Hỗ trợ nhiều mô hình đồng thời: Msty cho phép bạn chạy nhiều mô hình AI cùng lúc và so sánh kết quả (Split-chat), nhưng yêu cầu RAM lớn để đảm bảo tốc độ.

- Truy cập kho mô hình lớn: Ngoài các mô hình mặc định như Gemma 2, bạn có thể tải thêm mô hình từ Ollama hoặc Hugging Face.

- Giao diện thân thiện: Giao diện của Msty được thiết kế đẹp mắt, dễ sử dụng sau một thời gian làm quen.

- Cài đặt chi tiết:

- Tải Msty từ trang web chính thức, chọn phiên bản phù hợp (hỗ trợ GPU Nvidia/AMD hoặc chỉ CPU).

- Trong trình cài đặt, chọn “Set up local AI” để cài đặt cục bộ.

- Mô hình mặc định là Gemma 2 (1.6GB), phù hợp với máy tính yếu. Bạn có thể thay đổi mô hình hoặc tải thêm từ “Local AI Models” hoặc “Browse & Download Online Models”.

- Sau khi cài đặt, bạn có thể thêm tệp cá nhân vào “Knowledge Stack” và bắt đầu trò chuyện.

- Yêu cầu phần cứng:

- RAM tối thiểu: 8GB để chạy mô hình nhỏ (Gemma 2 2B). Với mô hình lớn hơn (Llama 3.1 8B), cần 16GB hoặc hơn.

- GPU: Tăng tốc đáng kể nếu có GPU, nhưng vẫn hoạt động trên CPU.

- Dung lượng lưu trữ: Mô hình nhỏ chiếm khoảng 1-2GB, mô hình lớn hơn có thể lên đến 12GB.

- Ưu điểm:

Một tính năng đặc biệt của Msty là bạn có thể yêu cầu nhiều mô hình AI tư vấn cùng một lúc. Tuy nhiên, PC của bạn phải có đủ bộ nhớ để phản hồi nhanh. Nếu không, bạn sẽ phải đợi rất lâu để có được câu trả lời hoàn chỉnh.

Một tính năng đặc biệt của Msty là bạn có thể yêu cầu nhiều mô hình AI tư vấn cùng một lúc. Tuy nhiên, PC của bạn phải có đủ bộ nhớ để phản hồi nhanh. Nếu không, bạn sẽ phải đợi rất lâu để có được câu trả lời hoàn chỉnh.- Tích hợp tệp cá nhân mạnh mẽ, phù hợp cho công việc nghiên cứu hoặc xử lý tài liệu.

- Hỗ trợ nhiều mô hình, linh hoạt cho các nhu cầu khác nhau.

- Giao diện đẹp, dễ sử dụng sau khi làm quen.

- Nhược điểm:

- Yêu cầu RAM lớn nếu chạy nhiều mô hình cùng lúc.

- Tính năng tìm kiếm trong tệp cá nhân chưa hoạt động tối ưu.

- Ứng dụng thực tế: Msty lý tưởng cho người dùng muốn tích hợp dữ liệu cá nhân vào chatbot, chẳng hạn như nhân viên văn phòng, nhà nghiên cứu, hoặc sinh viên cần xử lý tài liệu. Nếu bạn có máy tính mạnh, tính năng Split-chat sẽ giúp bạn so sánh hiệu suất của các mô hình AI khác nhau.

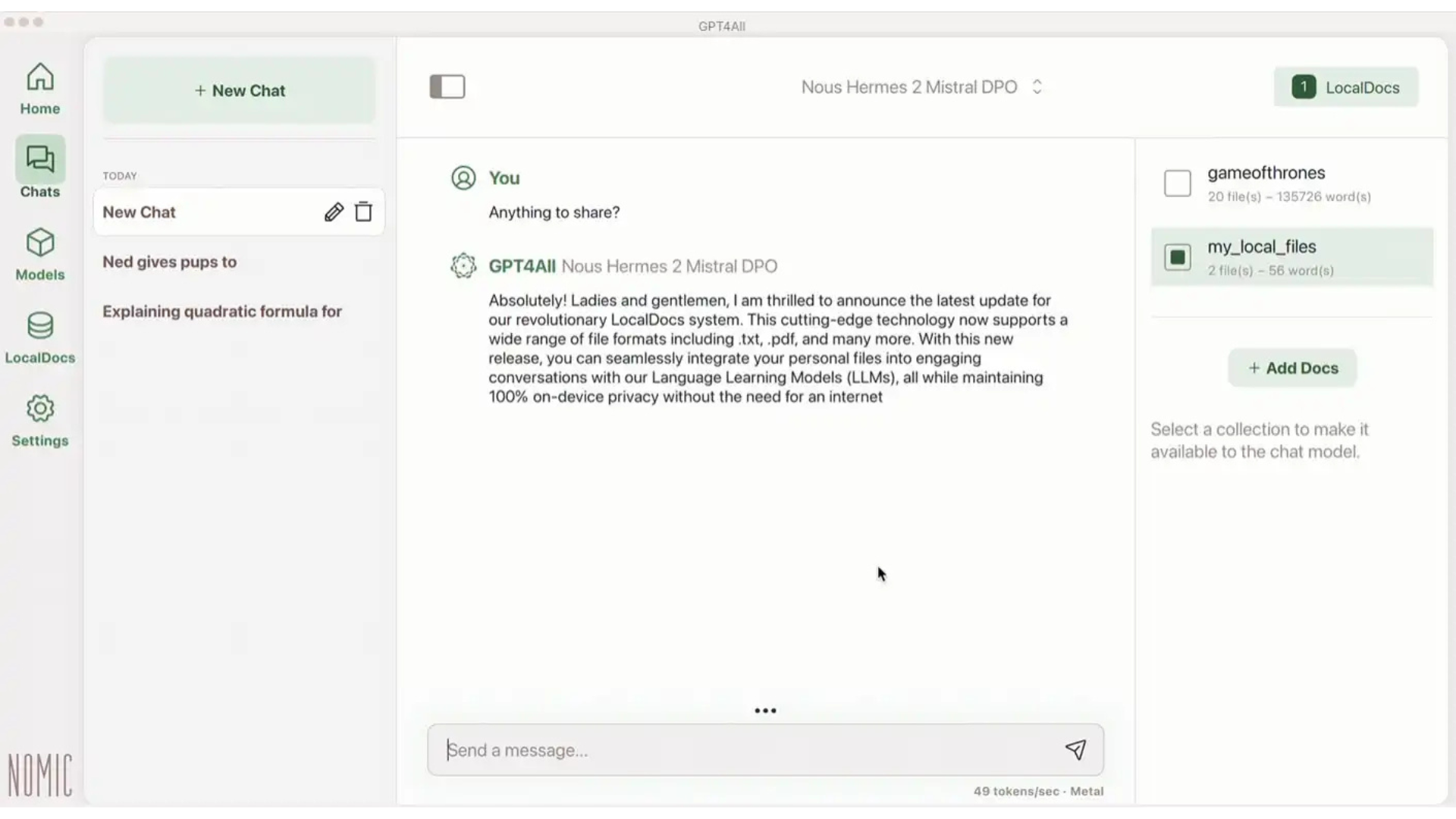

3. GPT4All: Đơn giản, dễ dùng, lựa chọn mô hình rõ ràng

Tổng quan:

GPT4All là một chatbot AI cục bộ với giao diện đơn giản, dễ sử dụng, và cung cấp một danh sách mô hình AI rõ ràng. Mặc dù số lượng mô hình mặc định không nhiều như Msty, nhưng GPT4All hỗ trợ tải thêm mô hình từ Hugging Face, đảm bảo tính linh hoạt.

- Tính năng nổi bật:

- Danh sách mô hình rõ ràng: Các mô hình mặc định bao gồm Llama 3 8B, Llama 3.2 3B, Microsoft Phi 3 Mini, và EM German Mistral. Mỗi mô hình đi kèm thông tin về RAM tối thiểu cần thiết.

- Tích hợp tệp cá nhân qua “Localdocs”: Bạn có thể tải lên tài liệu để chatbot tham khảo, nhưng không thể tùy chỉnh mô hình nhúng (embedding model).

- Tải mô hình từ Hugging Face: Nếu cần thêm mô hình, bạn có thể sử dụng chức năng tìm kiếm để tải từ kho lưu trữ.

- Cài đặt chi tiết:

- Tải GPT4All từ trang web chính thức và cài đặt (quá trình nhanh và đơn giản).

- Trong phần “Models”, chọn mô hình phù hợp (ví dụ: Llama 3 8B). Mỗi mô hình hiển thị yêu cầu RAM tối thiểu.

- Nếu cần thêm mô hình, sử dụng chức năng tìm kiếm để tải từ Hugging Face.

- Tải tài liệu cá nhân vào “Localdocs” và bắt đầu trò chuyện.

- Yêu cầu phần cứng:

- RAM tối thiểu: 8GB cho mô hình nhỏ. Với mô hình lớn hơn, cần 16GB hoặc hơn.

- GPU: Không bắt buộc, nhưng tăng tốc xử lý nếu có.

- Dung lượng lưu trữ: Mô hình nhỏ chiếm khoảng 1-2GB, mô hình lớn hơn có thể lên đến 10GB.

- Ưu điểm:

- Giao diện đơn giản, dễ sử dụng, phù hợp cho người mới.

- Thông tin RAM yêu cầu rõ ràng, giúp chọn mô hình dễ dàng.

- Ổn định trong quá trình sử dụng.

- Nhược điểm:

- Số lượng mô hình mặc định ít hơn Msty.

- Không thể tùy chỉnh mô hình nhúng khi tích hợp tệp cá nhân.

- Ứng dụng thực tế: GPT4All phù hợp cho người dùng muốn một chatbot cục bộ đơn giản, dễ cài đặt, và không yêu cầu nhiều tùy chỉnh. Nếu bạn cần một công cụ ổn định để trò chuyện hoặc xử lý tài liệu cơ bản, đây là lựa chọn tốt.

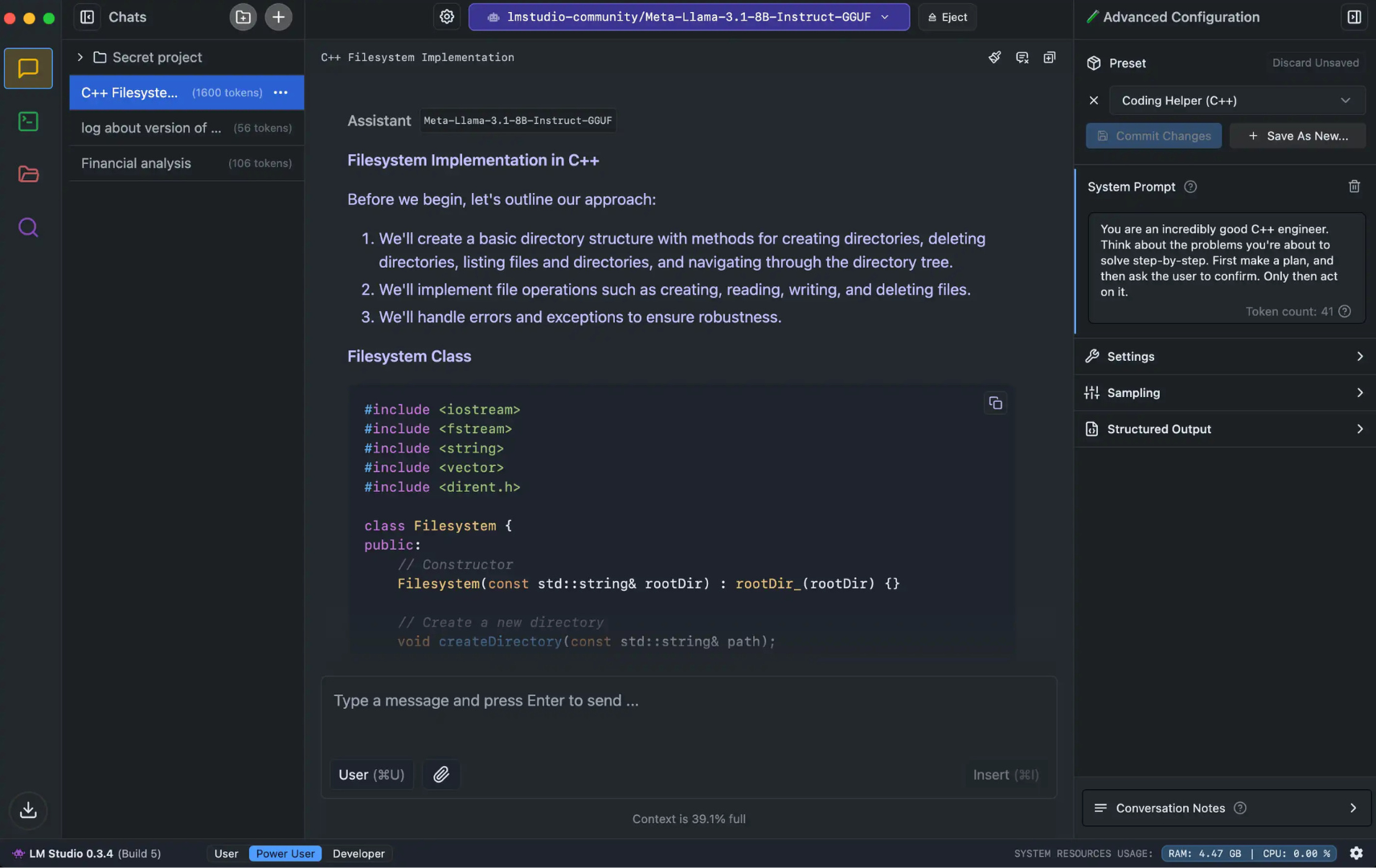

4. LM Studio: Lựa chọn cho người dùng nâng cao và nhà phát triển

Tổng quan:

LM Studio là một chatbot AI cục bộ được thiết kế chủ yếu cho người dùng nâng cao và nhà phát triển. Ngoài việc cung cấp truy cập vào nhiều mô hình từ Hugging Face, LM Studio còn cho phép tinh chỉnh mô hình AI và cung cấp thông tin chi tiết về hiệu suất.

- Tính năng nổi bật:

- Truy cập mô hình từ Hugging Face: LM Studio hỗ trợ tải nhiều mô hình, từ nhỏ (Llama 3.2 1B) đến lớn (Llama 3.1 8B).

- Tinh chỉnh mô hình (Developer View): Người dùng nâng cao có thể điều chỉnh các tham số của mô hình để tối ưu hóa hiệu suất.

- Tích hợp tài liệu vào trò chuyện: Bạn có thể tải tài liệu lên để chatbot tham khảo, nhưng không thể lưu trữ lâu dài. Nếu tài liệu dài, LM Studio sử dụng Retrieval Augmented Generation (RAG) để chọn lọc nội dung quan trọng.

- Thông tin hiệu suất chi tiết: Hiển thị số token trong câu trả lời, tốc độ xử lý, và các thông số khác, phù hợp cho nhà phát triển.

- Cài đặt chi tiết:

- Tải LM Studio từ trang web chính thức và cài đặt.

- Sau khi cài đặt, chọn “Get your first LLM” để tải mô hình mặc định (Llama 3.2 1B).

- Nếu cần thêm mô hình, sử dụng phím tắt Ctrl-Shift-M hoặc biểu tượng kính lúp “Discover” để tải từ Hugging Face.

- Chọn giao diện phù hợp (User, Power User, Developer) và bắt đầu sử dụng.

- Yêu cầu phần cứng:

- RAM tối thiểu: 8GB cho mô hình nhỏ (Llama 3.2 1B). Với mô hình lớn hơn, cần 16GB hoặc hơn.

- GPU: Tăng tốc đáng kể nếu có GPU Nvidia hoặc AMD.

- Dung lượng lưu trữ: Mô hình nhỏ chiếm khoảng 1-2GB, mô hình lớn hơn có thể lên đến 12GB.

- Ưu điểm:

- Phù hợp cho người dùng nâng cao và nhà phát triển nhờ khả năng tinh chỉnh mô hình.

- Cung cấp thông tin chi tiết về hiệu suất, hỗ trợ tối ưu hóa.

- Truy cập nhiều mô hình từ Hugging Face.

- Nhược điểm:

- Giao diện phức tạp hơn, không thân thiện với người mới.

- Tích hợp tài liệu chưa tối ưu, đặc biệt với tài liệu dài.

- Ứng dụng thực tế: LM Studio lý tưởng cho các nhà phát triển, kỹ sư AI, hoặc người dùng muốn tinh chỉnh mô hình để phù hợp với nhu cầu cụ thể. Nếu bạn cần một công cụ mạnh mẽ để nghiên cứu hoặc phát triển AI, đây là lựa chọn tốt.

So sánh tổng quan và khuyến nghị

| Chatbot | Ưu điểm | Nhược điểm | Phù hợp với |

| Llamafile | Dễ cài đặt, tích hợp hình ảnh, không cần internet | Giao diện cơ bản, tùy chỉnh hạn chế | Người mới, tác vụ đơn giản, phân tích hình ảnh cơ bản |

| Msty | Tích hợp tệp cá nhân mạnh mẽ, hỗ trợ nhiều mô hình, giao diện đẹp | Yêu cầu RAM lớn khi chạy nhiều mô hình, tích hợp tệp chưa tối ưu | Người cần xử lý tài liệu cá nhân, so sánh mô hình, máy tính mạnh |

| GPT4All | Giao diện đơn giản, thông tin RAM rõ ràng, ổn định | Ít mô hình mặc định, không tùy chỉnh mô hình nhúng | Người mới, tác vụ cơ bản, cần công cụ ổn định |

| LM Studio | Tinh chỉnh mô hình, thông tin hiệu suất chi tiết, nhiều mô hình từ Hugging Face | Giao diện phức tạp, tích hợp tài liệu chưa tối ưu | Nhà phát triển, người dùng nâng cao, nghiên cứu AI |

Yêu cầu phần cứng chung và khuyến nghị

- RAM:

- Tối thiểu 8GB: Đủ để chạy các mô hình nhỏ như Gemma 2 2B, Llama 3.2 1B. Tuy nhiên, tốc độ xử lý có thể chậm nếu không có GPU.

- Khuyến nghị 16GB trở lên: Đảm bảo hiệu suất tốt với các mô hình lớn (Llama 3.1 8B) hoặc khi chạy nhiều mô hình cùng lúc.

- GPU:

- Không bắt buộc, nhưng nếu có GPU Nvidia hoặc AMD, tốc độ xử lý sẽ nhanh hơn đáng kể. Hầu hết các chatbot đều hỗ trợ tăng tốc GPU.

- Nếu không có GPU, CPU sẽ xử lý toàn bộ, dẫn đến thời gian phản hồi lâu hơn.

- Dung lượng lưu trữ:

- Mô hình nhỏ (1-2GB): Gemma 2, Llama 3.2 1B.

- Mô hình lớn (10-12GB): Llama 3.1 8B, Gemma 2 7B.

- Đảm bảo bạn có đủ dung lượng trống để tải và lưu trữ các mô hình.

Lợi ích của việc sử dụng chatbot AI cục bộ

- Bảo mật và riêng tư: Vì không cần kết nối internet, dữ liệu của bạn được xử lý hoàn toàn trên máy tính, đảm bảo không bị gửi đến máy chủ bên ngoài.

- Không phụ thuộc vào mạng: Bạn có thể sử dụng chatbot mọi lúc, mọi nơi, ngay cả khi không có kết nối internet.

- Tiết kiệm chi phí: Các chatbot này miễn phí và không giới hạn thời gian sử dụng, không giống như một số dịch vụ AI trực tuyến yêu cầu trả phí.

- Tùy chỉnh linh hoạt: Bạn có thể chọn mô hình phù hợp với phần cứng, tích hợp tệp cá nhân, hoặc tinh chỉnh mô hình (với LM Studio).

Kết luận

Việc chạy chatbot AI cục bộ trên PC mang lại nhiều lợi ích, từ bảo mật, tiết kiệm chi phí, đến khả năng tùy chỉnh. Tùy thuộc vào nhu cầu và cấu hình máy tính, bạn có thể chọn một trong bốn chatbot trên:

- Llamafile nếu bạn cần một công cụ đơn giản, dễ dùng, và hỗ trợ hình ảnh.

- Msty nếu bạn muốn tích hợp tệp cá nhân và chạy nhiều mô hình cùng lúc.

- GPT4All nếu bạn ưu tiên giao diện thân thiện, ổn định, và thông tin RAM rõ ràng.

- LM Studio nếu bạn là người dùng nâng cao hoặc nhà phát triển cần tinh chỉnh mô hình.

Hãy kiểm tra cấu hình máy tính của bạn và thử nghiệm các chatbot này để tìm ra lựa chọn phù hợp nhất. Với sự phát triển của công nghệ AI, việc sử dụng chatbot cục bộ sẽ ngày càng trở nên phổ biến và dễ tiếp cận hơn.

Một tính năng đặc biệt của Msty là bạn có thể yêu cầu nhiều mô hình AI tư vấn cùng một lúc. Tuy nhiên, PC của bạn phải có đủ bộ nhớ để phản hồi nhanh. Nếu không, bạn sẽ phải đợi rất lâu để có được câu trả lời hoàn chỉnh.

Một tính năng đặc biệt của Msty là bạn có thể yêu cầu nhiều mô hình AI tư vấn cùng một lúc. Tuy nhiên, PC của bạn phải có đủ bộ nhớ để phản hồi nhanh. Nếu không, bạn sẽ phải đợi rất lâu để có được câu trả lời hoàn chỉnh.