Blog

Cách biến Mac của bạn thành ChatGPT mà không mất tiền

Mẫu ngôn ngữ mới nhất gpt-oss-20b của OpenAI cho phép máy Mac của bạn chạy AI theo phong cách ChatGPT mà không cần đăng ký, không cần Internet và không ràng buộc. Dưới đây là cách để bắt đầu.

Vào ngày tháng , OpenAI đã phát hành các mô hình ngôn ngữ lớn mã nguồn mở (open-weight) đầu tiên của họ sau nhiều năm, cho phép người dùng Mac chạy các công cụ kiểu ChatGPT ngoại tuyến. Với thiết lập phù hợp, nhiều máy Mac dùng chip Apple Silicon giờ đây có thể xử lý các tác vụ AI nâng cao mà không cần đăng ký hay kết nối Internet.

Việc chạy một mô hình AI mạnh mẽ trên máy Mac trước đây đòi hỏi phải trả tiền cho dịch vụ đám mây hoặc phải xử lý phần mềm máy chủ phức tạp. Các mô hình mới gpt-oss-20b và gpt-oss-120b đã thay đổi điều đó.

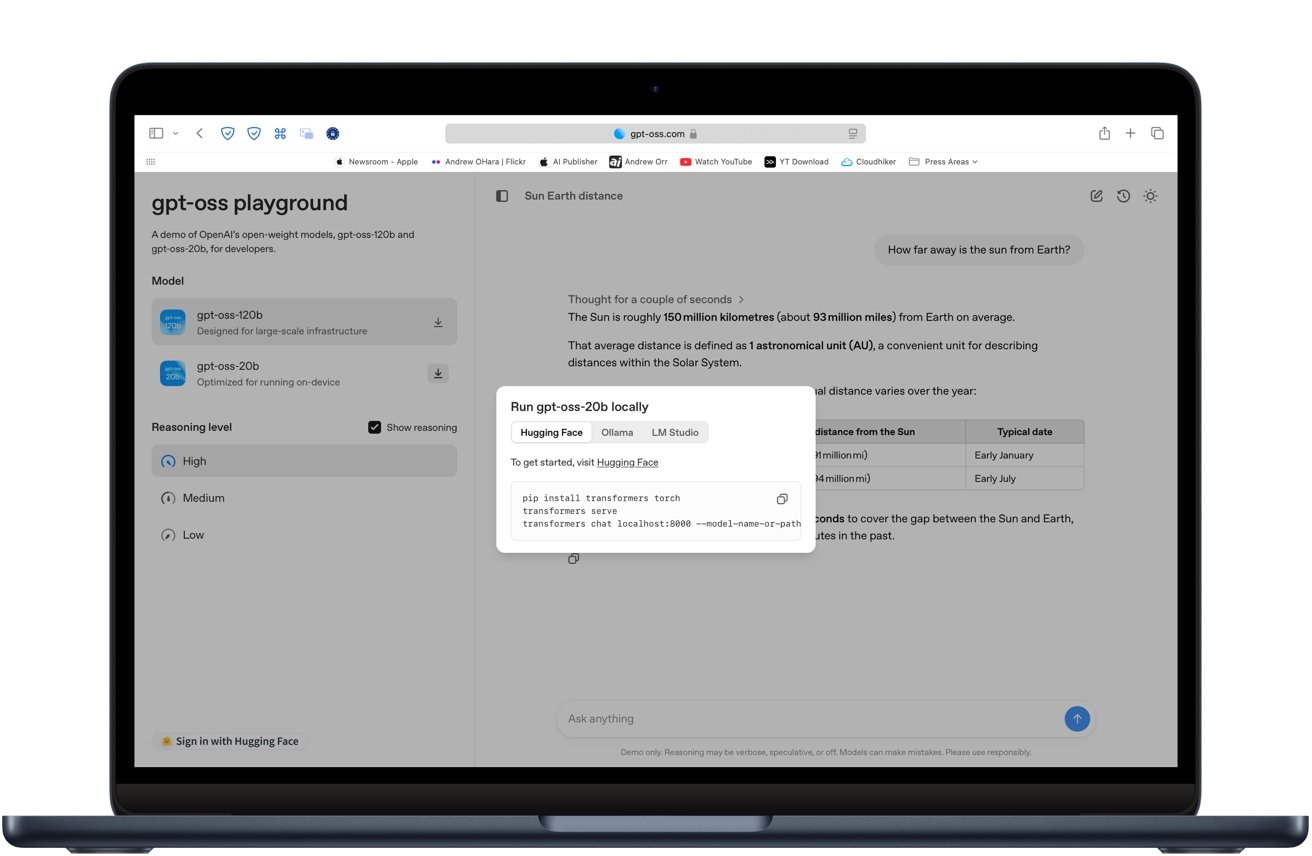

Các mô hình này cung cấp các tệp trọng số (weights) có thể tải xuống, hoạt động với các công cụ AI cục bộ phổ biến như LM Studio và Ollama.

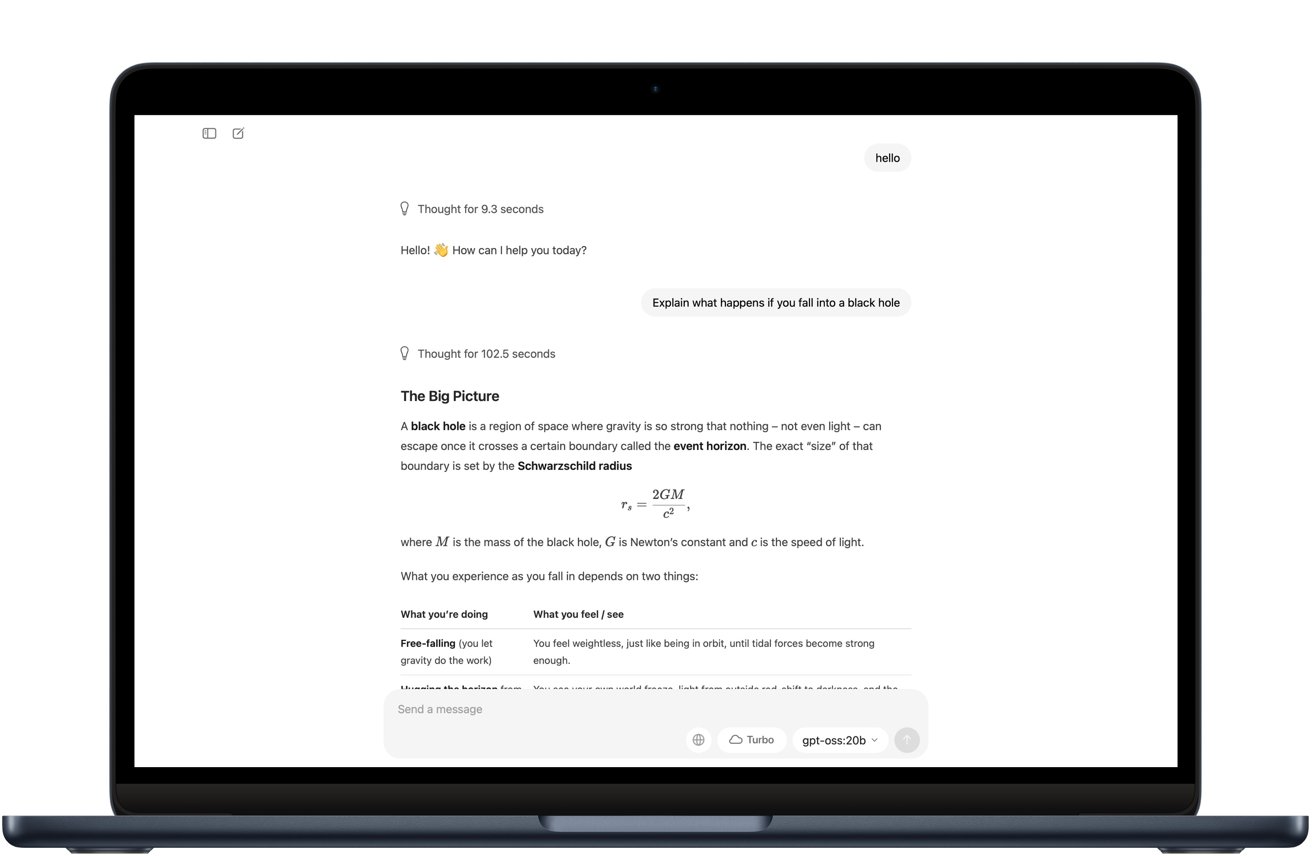

Bạn có thể dùng thử mô hình này ngay trong trình duyệt của mình trước khi tải xuống bất cứ thứ gì bằng cách truy cập gpt-oss.com. Trang web cung cấp bản demo miễn phí của mỗi mô hình để bạn có thể xem cách nó xử lý việc viết, lập trình và các câu hỏi chung.

Những gì bạn cần để chạy mô hình

Chúng tôi khuyến nghị ít nhất là chip M2 và RAM. Nhiều hơn thì càng tốt. Nếu bạn có bộ xử lý M1, chúng tôi khuyên dùng phiên bản Max hoặc Ultra. Mac Studio là một lựa chọn tuyệt vời cho việc này, nhờ khả năng tản nhiệt bổ sung.

Mô hình này hoạt động hơi chật vật trên chiếc MacBook Air với chip M3 của chúng tôi. Và như bạn có thể đoán, máy cũng nóng lên đáng kể.

Hãy hình dung nó giống như việc chơi game trên Mac. Bạn có thể làm được, nhưng nó có thể rất khắt khe về tài nguyên.

Để bắt đầu, bạn sẽ cần một trong các công cụ sau:

- LM Studio — một ứng dụng miễn phí với giao diện trực quan.

- Ollama — một công cụ dòng lệnh (command-line) có khả năng quản lý mô hình.

- MLX — Khung học máy (machine learning framework) của Apple, được cả hai ứng dụng trên sử dụng để tăng tốc xử lý.

Các ứng dụng này sẽ xử lý việc tải xuống mô hình, thiết lập và kiểm tra khả năng tương thích.

Sử dụng Ollama

Ollama là một công cụ nhẹ cho phép bạn chạy các mô hình AI cục bộ từ dòng lệnh với thiết lập tối thiểu.

- Cài đặt Ollama bằng cách làm theo hướng dẫn tại ollama.com.

- Mở Terminal và chạy lệnh

ollama run gpt-oss-20bđể tải xuống và khởi chạy mô hình. - Ollama sẽ xử lý việc thiết lập, bao gồm tải xuống phiên bản lượng tử hóa (quantized) phù hợp.

- Sau khi mô hình tải xong, bạn sẽ thấy một dấu nhắc (prompt) nơi bạn có thể bắt đầu trò chuyện ngay lập tức.

Nó hoạt động hệt như ChatGPT, nhưng mọi thứ đều chạy ngay trên máy Mac của bạn mà không cần kết nối Internet. Trong thử nghiệm của chúng tôi, tệp tải xuống có dung lượng khoảng , vì vậy tốc độ Wi-Fi của bạn sẽ quyết định bước này mất bao lâu.

Trên chiếc MacBook Air với chip M3 và RAM, mô hình vẫn chạy được, nhưng thời gian phản hồi câu hỏi chậm hơn đáng kể so với GPT- trên đám mây. Mặc dù vậy, các câu trả lời vẫn đến được mà không cần bất kỳ kết nối Internet nào.

Hiệu suất và giới hạn

Mô hình tỷ tham số này đã được nén sang định dạng -bit. Điều đó cho phép mô hình chạy mượt mà trên các máy Mac có RAM cho nhiều tác vụ khác nhau:

- Viết và tóm tắt văn bản.

- Trả lời câu hỏi.

- Tạo và gỡ lỗi mã (debugging code).

- Gọi hàm có cấu trúc (Structured function calling).

Nó chậm hơn so với GPT- dựa trên đám mây đối với các tác vụ phức tạp, nhưng đủ đáp ứng cho hầu hết công việc cá nhân và phát triển. Mô hình lớn hơn đòi hỏi đến bộ nhớ, khiến nó chỉ khả thi cho các máy trạm cao cấp hoặc môi trường nghiên cứu.

Tại sao nên chạy AI cục bộ?

Việc suy luận cục bộ (Local inference) giúp dữ liệu của bạn được bảo mật, vì không có gì rời khỏi thiết bị của bạn. Nó cũng giúp tránh các khoản phí API hoặc phí đăng ký liên tục và giảm độ trễ bằng cách loại bỏ nhu cầu gọi mạng.

Vì các mô hình được phát hành theo giấy phép Apache , bạn có thể tinh chỉnh chúng cho các quy trình làm việc tùy chỉnh. Sự linh hoạt đó cho phép bạn định hình hành vi của AI cho các dự án chuyên biệt.

Gpt-oss-20b là một lựa chọn vững chắc nếu bạn cần một mô hình AI chạy hoàn toàn trên máy Mac của mình mà không cần kết nối Internet. Nó riêng tư, miễn phí sử dụng và đáng tin cậy sau khi được thiết lập. Sự đánh đổi ở đây là tốc độ và độ tinh tế.

Trong thử nghiệm, nó mất nhiều thời gian hơn để phản hồi so với GPT- và đôi khi cần phải chỉnh sửa một chút đối với các câu trả lời phức tạp. Tuy nhiên, đối với việc viết thông thường, lập trình cơ bản và nghiên cứu, nó hoạt động tốt.

Nếu việc duy trì trạng thái ngoại tuyến quan trọng hơn hiệu suất đối với bạn, gpt-oss-20b là một trong những tùy chọn tốt nhất bạn có thể chạy hiện nay. Đối với kết quả nhanh và độ chính xác cao, một mô hình dựa trên đám mây (cloud-based) vẫn là lựa chọn phù hợp hơn.

Mẹo để có trải nghiệm tốt nhất

- Sử dụng phiên bản lượng tử hóa (quantized) của mô hình để giảm độ chính xác từ số dấu phẩy động -bit xuống số nguyên -bit hoặc -bit. Lượng tử hóa mô hình có nghĩa là giảm độ chính xác của nó, điều này giúp giảm đáng kể việc sử dụng bộ nhớ trong khi vẫn giữ độ chính xác gần với bản gốc. Các mô hình gpt-oss của OpenAI sử dụng định dạng -bit gọi là MXFP4, cho phép mô hình chạy trên các máy Mac có khoảng RAM.

- Nếu máy Mac của bạn có dưới RAM, hãy chọn các mô hình nhỏ hơn trong phạm vi đến tỷ tham số.

- Đóng các ứng dụng tiêu tốn nhiều bộ nhớ trước khi bắt đầu phiên làm việc và bật tính năng tăng tốc MLX hoặc Metal khi có sẵn để có hiệu suất tốt hơn.

Với thiết lập phù hợp, máy Mac của bạn có thể chạy các mô hình AI ngoại tuyến mà không cần đăng ký hoặc Internet, giúp dữ liệu của bạn được bảo mật. Nó sẽ không thay thế được các mô hình đám mây cao cấp cho mọi tác vụ, nhưng nó là một công cụ ngoại tuyến mạnh mẽ khi quyền riêng tư và khả năng kiểm soát là quan trọng.