Blog

Cách cài đặt và sử dụng Ollama để chạy AI LLM cục bộ trên PC Windows 11

Hầu hết chúng ta hiện nay thường tương tác phổ biến nhất với AI thông qua các công cụ đám mây như ChatGPT hoặc Copilot. Những công cụ này yêu cầu kết nối internet để sử dụng, nhưng bù lại, chúng có thể sử dụng trên hầu hết mọi thiết bị.

Tuy nhiên, không phải ai cũng muốn dựa vào đám mây để sử dụng AI, đặc biệt là các nhà phát triển. Vì vậy, bạn muốn LLM chạy cục bộ trên máy tính của mình. Đó chính là lúc Ollama xuất hiện.

Ollama là một công cụ suy luận cho phép bạn chạy nhiều loại LLM gốc trên PC. Đây không phải là cách duy nhất để đạt được điều này, nhưng là một trong những cách đơn giản nhất.

Sau khi cài đặt và chạy, bạn có thể làm được rất nhiều việc với Ollama và các LLM bạn đang sử dụng, nhưng bước đầu tiên là thiết lập. Chúng tôi sẽ hướng dẫn bạn từng bước.

Những gì bạn cần để chạy Ollama

Việc chạy Ollama không quá khó khăn và có thể chạy trên nhiều loại phần cứng. Nó tương thích với Windows 11, macOS và Linux, và bạn thậm chí có thể sử dụng nó thông qua các bản phân phối Linux bên trong Windows 11 thông qua WSL.

Bạn sẽ cần một phần cứng mạnh mẽ hơn để chạy các LLM. Mô hình càng lớn, bạn càng cần nhiều sức mạnh. Các mô hình sẽ cần một GPU để chạy, hiện tại, nó vẫn chưa được tối ưu hóa để chạy trên NPU trên PC Copilot+ mới.

Về cơ bản, nếu bạn có một PC khá hiện đại với ít nhất 8GB RAM và một GPU chuyên dụng, bạn sẽ có thể tận dụng được Ollama.

Nếu bạn không có GPU chuyên dụng thì Ollama vẫn có thể được sử dụng, nhưng nó sẽ tận dụng CPU và RAM của bạn. Điều này có nghĩa là bạn không đạt được hiệu suất tương tự như trên GPU chuyên dụng, nhưng nó vẫn có thể hoạt động.

Các quy tắc tương tự cũng được áp dụng. Bộ nhớ là yếu tố quan trọng nhất khi sử dụng LLM cục bộ. Nếu bạn có nhiều bộ nhớ, bạn có thể chạy các mô hình lớn hơn. Nhưng ngay cả trên CPU máy tính xách tay, bạn vẫn có thể sử dụng các mô hình 1b, 3b và 4b một cách thành công.

Cách cài đặt Ollama trên Windows 11

Cài đặt Ollama trên Windows 11 rất đơn giản, chỉ cần tải xuống trình cài đặt từ trang web (hoặc kho lưu trữ GitHub) và cài đặt.

Chỉ cần vậy thôi.

Sau khi cài đặt và mở ra, bạn sẽ không thấy bất kỳ thứ gì trên màn hình nền. Nó chạy hoàn toàn ở chế độ nền, nhưng bạn sẽ thấy biểu tượng của nó trên thanh tác vụ.

Bạn cũng có thể kiểm tra xem nó có chạy đúng không bằng cách điều hướng đến localhost:11434 trong trình duyệt web.

Cài đặt và chạy LLM đầu tiên của bạn trên Ollama

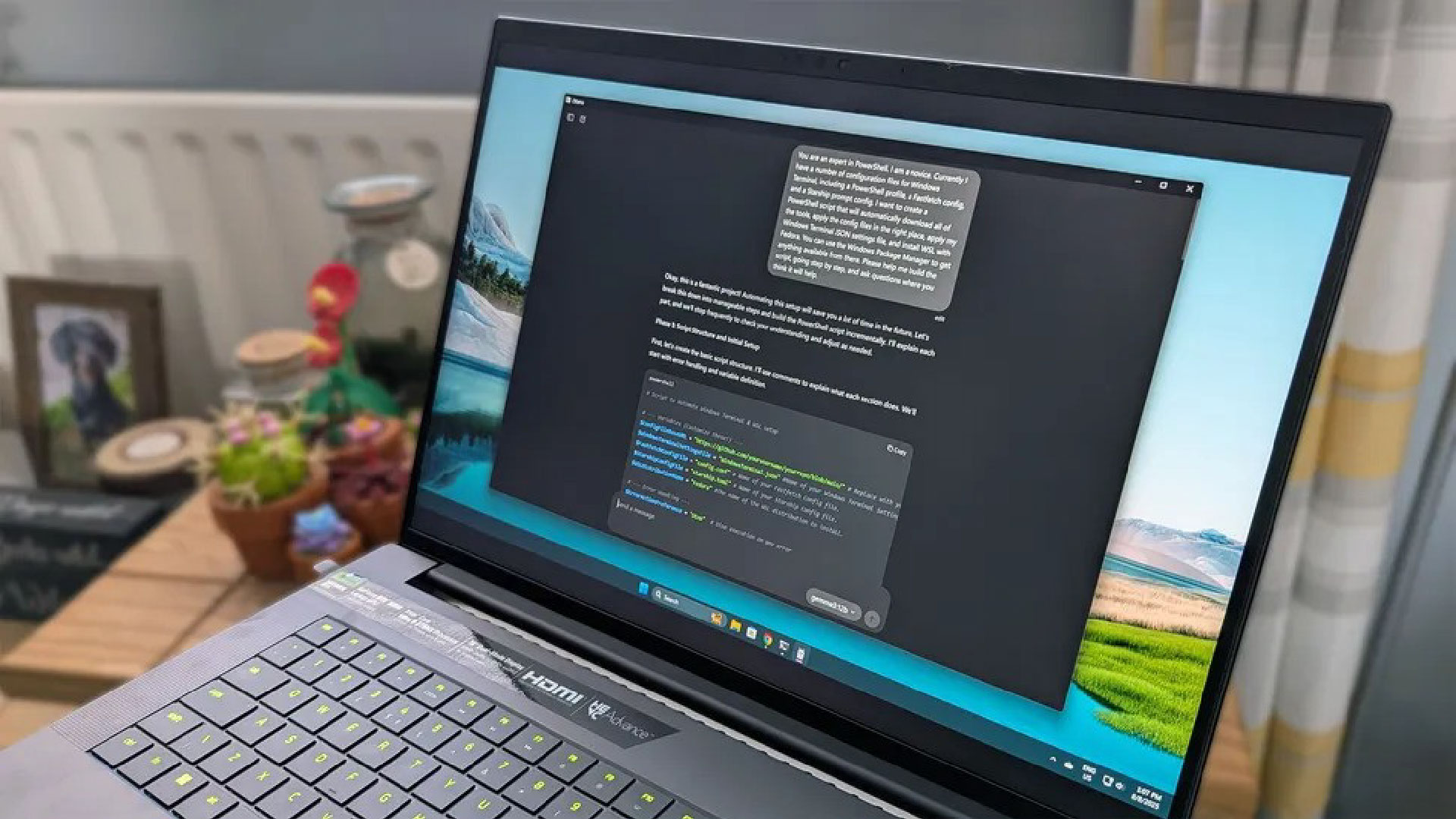

Ollama hiện có cả CLI (giao diện dòng lệnh) và giao diện người dùng đồ họa (GUI). Tuy nhiên, việc sử dụng thành thạo PowerShell hoặc WSL vẫn rất tiện lợi để tận dụng tối đa tính năng của nó, vì giao diện người dùng đồ họa (GUI) vẫn còn rất cơ bản.

Bạn cũng có thể sử dụng các tùy chọn nâng cao hơn của bên thứ ba. Dễ nhất là tiện ích mở rộng trình duyệt Page Assist, cho phép khởi chạy một ứng dụng web đầy đủ để sử dụng với Ollama. Một tùy chọn phổ biến hơn nhưng cũng khó cài đặt hơn một chút là OpenWebUI.

Hai lệnh chính trong terminal bạn cần biết là:

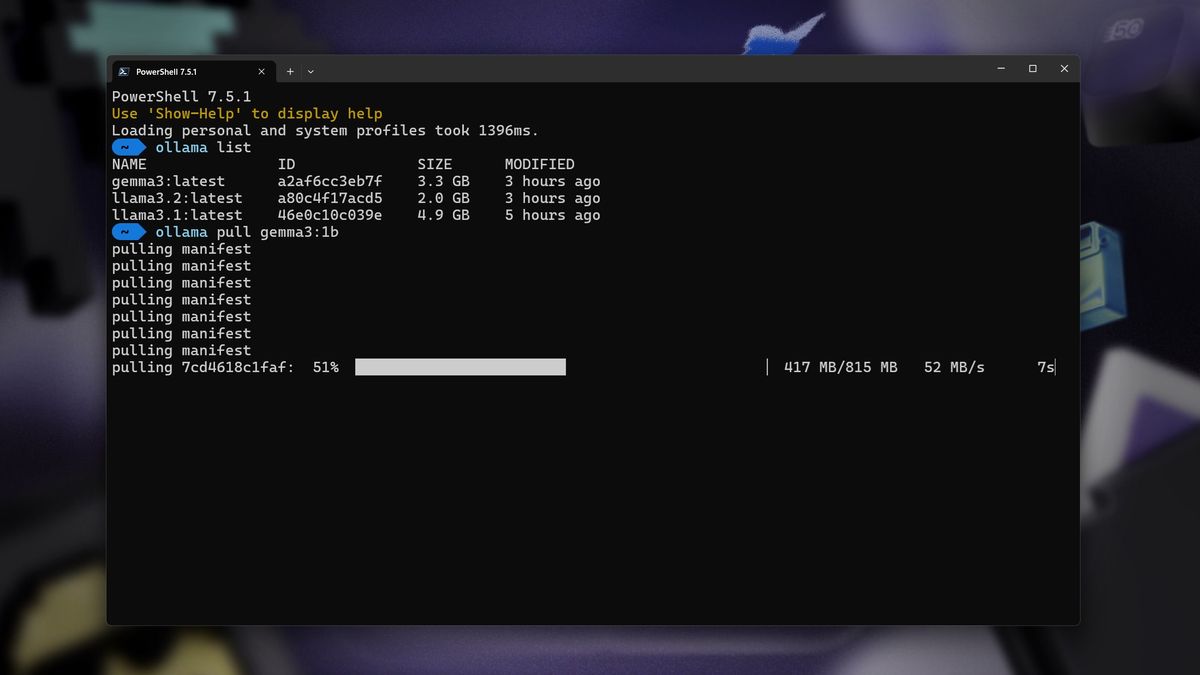

ollama pull <llm name>

ollama run <llm name>

Chỉ cần lấy nó trước, rồi chạy. Tất cả những gì bạn cần biết là tên chính xác của LLM bạn muốn cài đặt, và những thông tin này có sẵn trên trang web Ollama.

Ví dụ: nếu bạn muốn cài đặt Google Gemma 3 LLM với 1 tỷ tham số, bạn sẽ nhập như sau:

ollama pull gemma3:1b Bằng cách thêm :1b sau tên, bạn đang chỉ định rằng bạn muốn mô hình 1 tỷ tham số. Nếu bạn muốn mô hình 4 tỷ tham số, bạn sẽ đổi thành :4b.

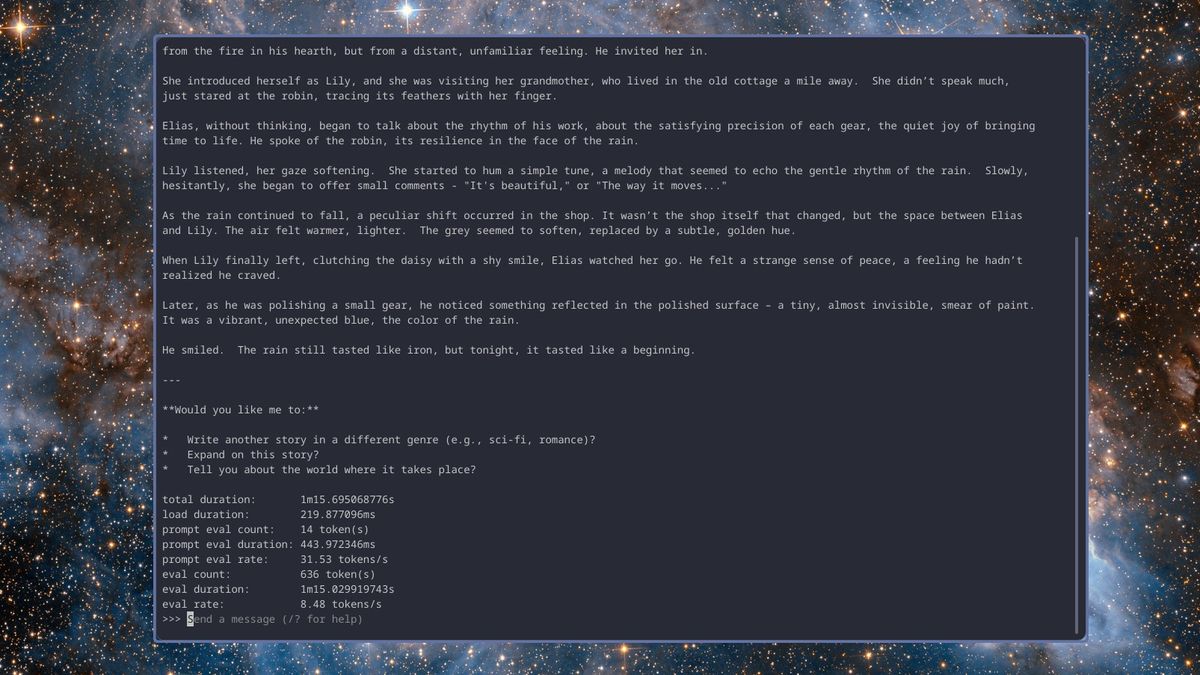

Việc chạy các mô hình trong terminal sẽ mở ra trải nghiệm chatbot quen thuộc, cho phép bạn nhập lời nhắc và nhận phản hồi. Tất cả đều chạy cục bộ trên máy của bạn. Nếu bạn muốn xem hiệu suất của nó, hãy thêm thẻ –verbose khi khởi chạy.

Để thoát khỏi mô hình và quay lại PowerShell, bạn chỉ cần nhập /bye và nó sẽ thoát.

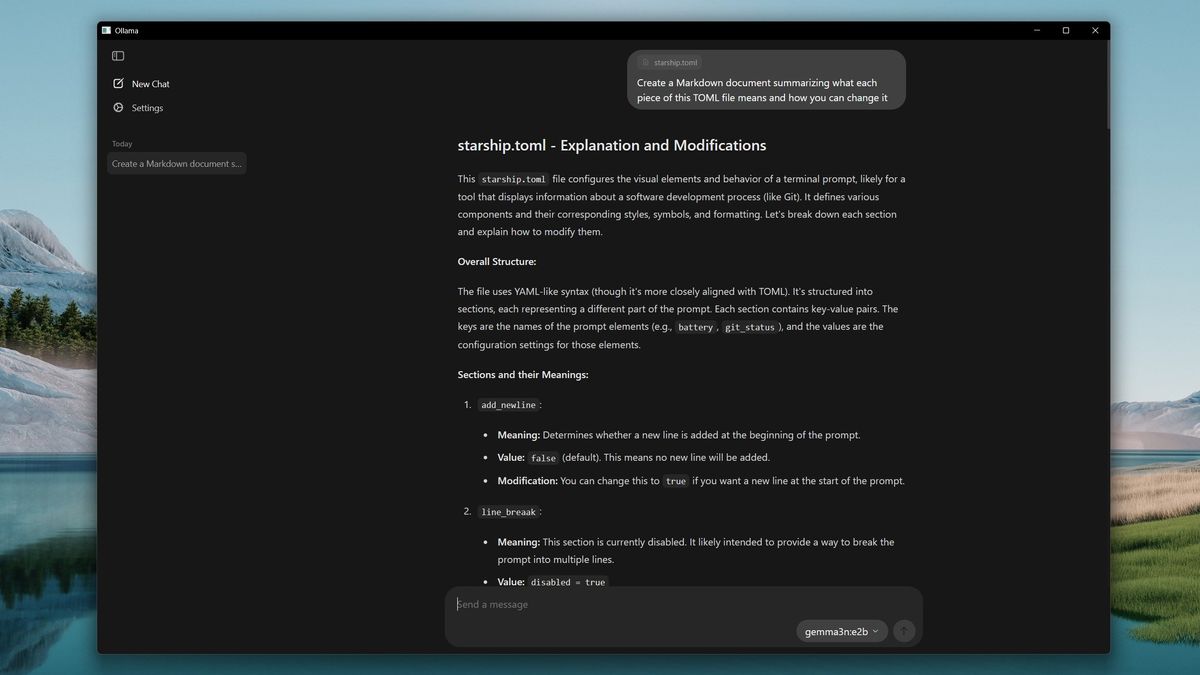

Ngoài ra, bạn có thể khởi chạy giao diện người dùng đồ họa Ollama và bắt đầu. Bạn vẫn có thể kéo một mô hình mới tại đây bằng cách tìm kiếm nó trong hộp thả xuống, nhập một thông báo đơn giản như “hi” và nó sẽ kéo mô hình cho bạn.

Page Assist và OpenWebUI có các công cụ quản lý mô hình tiên tiến hơn, cho phép bạn tìm kiếm, kéo và xóa các mô hình một cách dễ dàng.

Bài viết này bao gồm những kiến thức cơ bản nhất về cách thiết lập Ollama trên máy tính của bạn để sử dụng hàng loạt các chương trình LLM có sẵn. Trải nghiệm cốt lõi cực kỳ đơn giản và thân thiện với người dùng, và hầu như không yêu cầu kiến thức kỹ thuật để thiết lập. Nếu tôi làm được, bạn cũng có thể làm được!